Die US-Polizei nutzt eine Technologie, die den Ton ihrer Körperkameras aufzeichnet, um ihre Vorfallberichte in acht Sekunden zu verfassen.

Einige Polizeidienststellen in den USA experimentieren mit der Nutzung von Chatbots mit künstlicher Intelligenz (KI), um die ersten Entwürfe ihrer Vorfallberichte zu erstellen.

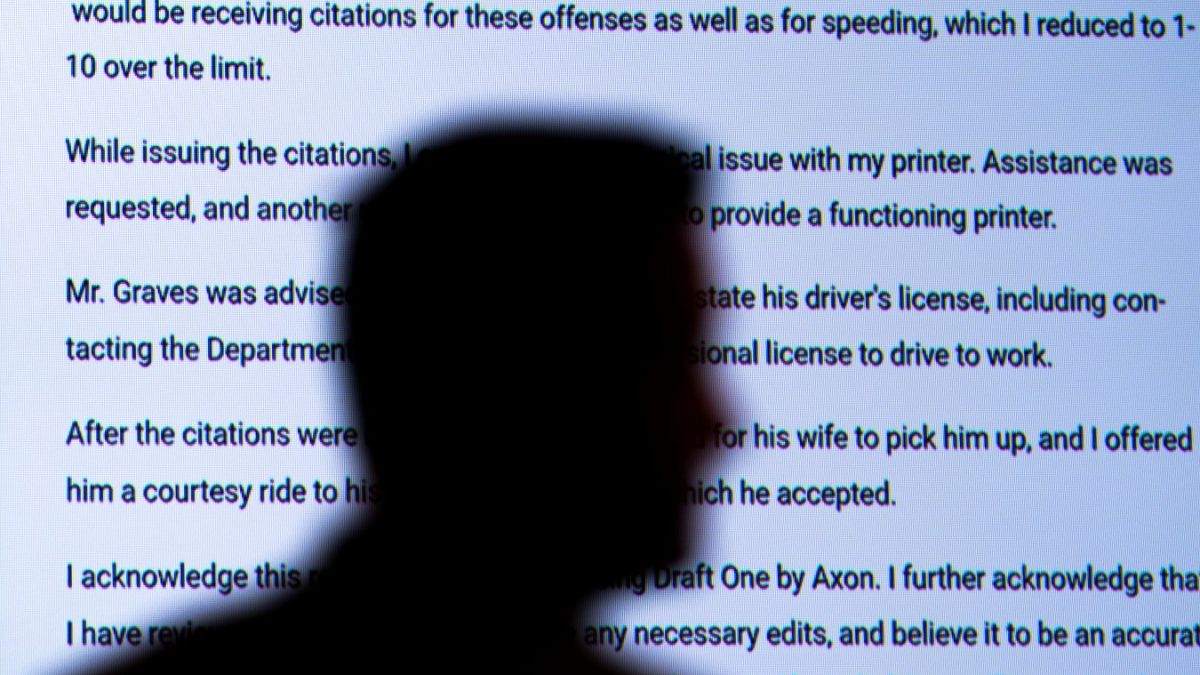

Eine Technologie mit demselben generativen KI-Modell wie ChatGPT zieht den Ton und den Funkverkehr aus einem Mikrofon der Körperkamera der Polizei und kann in acht Sekunden einen Bericht ausspucken.

„Es war ein besserer Bericht, als ich ihn je hätte schreiben können, und er war hundertprozentig zutreffend. Er war flüssiger“, sagte Matt Gilmore, ein Polizeisergeant der Polizei von Oklahoma City.

Das neue Tool könnte Teil eines wachsenden KI-Toolkits sein, das die US-Polizei bereits nutzt und zu dem etwa Algorithmen gehören, die Nummernschilder lesen, Gesichter von Verdächtigen erkennen oder Schüsse registrieren.

Wenige Richtlinien für die Verwendung von KI-Berichten

Rick Smith, CEO und Gründer von Axon, dem Unternehmen hinter dem KI-Produkt Draft One, sagte, die KI habe das Potenzial, den Papierkram, den die Polizei erledigen müsse, abzuschaffen, sodass ihr mehr Zeit für ihre eigentliche Arbeit bleibe.

Doch wie bei anderen KI-Technologien, die von der Polizei eingesetzt werden, gibt es auch hier Bedenken, räumte Smith ein.

Er sagte, sie kämen hauptsächlich von Staatsanwälten, die sicherstellen wollten, dass die Polizeibeamten den Inhalt ihres Berichts kennen, falls sie in einem Strafverfahren über das aussagen müssten, was sie am Tatort gesehen hätten.

„Sie wollen nie einen Beamten in den Zeugenstand rufen, der sagt: ‚Das hat die KI geschrieben, nicht ich‘“, sagte Smith.

Die Einführung KI-generierter Polizeiberichte ist so neu, dass es kaum oder gar keine Leitlinien für ihre Nutzung gibt.

In Oklahoma City zeigten sie das Tool den örtlichen Staatsanwälten, die jedoch zur Vorsicht mahnten, bevor es in Kriminalfällen mit hohem Risiko eingesetzt wird.

Doch es gibt auch Beispiele aus anderen Städten in den USA, wo die Beamten die Technologie in jedem Fall und nach eigenem Ermessen einsetzen können.

Bedenken hinsichtlich rassistischer Vorurteile bei KI

Der Rechtswissenschaftler Andrew Ferguson wünscht sich, dass vor der Einführung dieser Technologie eine stärkere öffentliche Diskussion über deren Nutzen und potenziellen Schaden stattfindet.

Zum einen neigen die großen Sprachmodelle hinter KI-Chatbots dazu, falsche Informationen zu erfinden, ein Problem bekannt als Halluzination die einem Polizeibericht überzeugende und kaum zu erkennende Unwahrheiten hinzufügen könnten.

„Ich befürchte, dass die Automatisierung und die Benutzerfreundlichkeit der Technologie dazu führen könnten, dass Polizisten beim Schreiben weniger sorgfältig sind“, sagte Ferguson, Juraprofessor an der American University, der an dem voraussichtlich ersten Artikel in einer juristischen Fachzeitschrift über die aufkommende Technologie arbeitet.

Ferguson sagte, ein Polizeibericht sei wichtig, um festzustellen, ob der Verdacht eines Beamten „die Freiheitsentziehung einer Person rechtfertigt“. Manchmal ist es die einzige Aussage, die ein Richter sieht, insbesondere bei geringfügigen Straftaten.

Auch von Menschen erstellte Polizeiberichte hätten Mängel, sagte Ferguson, aber es sei eine offene Frage, welche zuverlässiger seien.

Bedenken, dass rassistische Vorurteile und Voreingenommenheiten in der Gesellschaft in die KI-Technologie einfließen könnten, sind nur ein Teil dessen, was der Gemeindeaktivist Aurelius Francisco aus Oklahoma City an dem neuen Tool „zutiefst beunruhigend“ findet, wie er von AP erfuhr.

Er sagte, die Automatisierung dieser Berichte werde „der Polizei die Möglichkeit nehmen, Gemeindemitglieder zu schikanieren, zu überwachen und ihnen Gewalt anzutun. Das erleichtert zwar die Arbeit der Polizisten, erschwert aber das Leben von Schwarzen und Braunen.“